Web Scraper 快速抓取数据的实战笔记

今天在搭建“档案馆项目”的过程中,由于数据量大且层级深,AI 与 Web Scraper 插件的配合大大提升了效率。特别参考了 B 站优质教程(视频链接),成功解决了多页码与详情页参数的抓取难题。

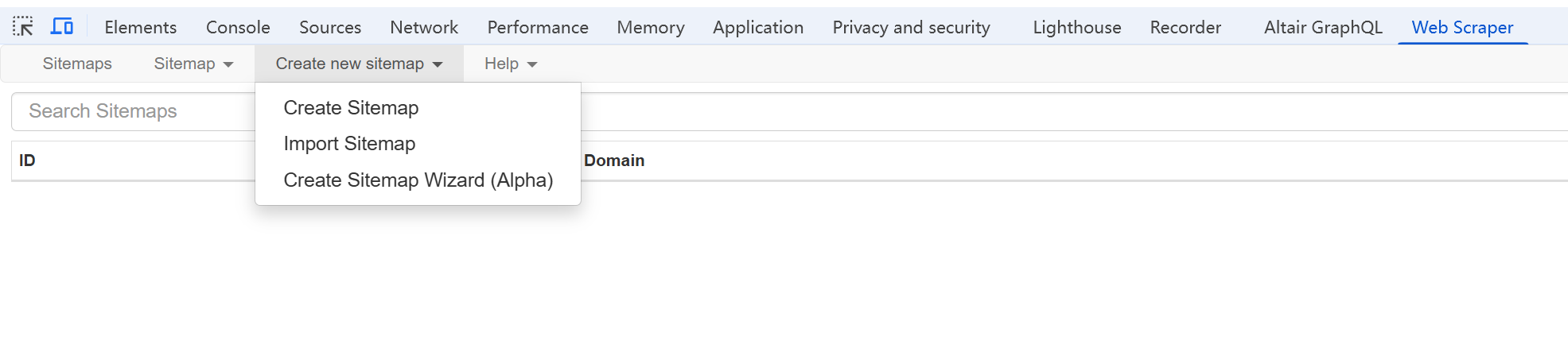

核心步骤

- 建立列表页 Sitemap: 首先确定 Start URL 规律,通过 Element 容器圈定商品方块,确保标题、链接与图片一一对应。

- 建立详情页(深度)Sitemap: 这是实现数据完整性的关键。注意:所有详情页需要抓取的字段(如比例 bili、相册 gallery)必须嵌套在列表页的 Link(URL)选择器内部,利用 _follow 逻辑点进内页。

踩坑经验与避错指南

- 处理复杂的 DOM 嵌套: 当列表页(或详情页)的 <li> 标签中还嵌套了 <ul> 时,不能直接抓取。需要先针对子级 <ul> 创建一个 Element 容器,再在该容器内创建具体的抓取字段。

- 关于 Data Preview 的“假报错”: 在配置第二层(详情页)选择器时,直接点击子项的 Data preview 可以看到预览值,但在 _root 根目录下点击预览往往会因层级未加载而报错。 经验总结:此时不必纠结报错,只要子项预览正常,直接点击 Sitemap -> Scrape 启动爬虫。让浏览器完整运行一次循环,便能拿到完整的对齐数据。

- 数据清洗与导出: 建议将相册图片设置为 Multiple Records in One Column(单列多记录),这样方便后续通过 Node.js 脚本批量下载并同步到 网站后台。